Nowe badanie wspierane przez Apple pokazuje, iż dane behawioralne z Apple Watcha i iPhone’a – takie jak sen, ruch, aktywność czy stabilność chodu – mogą być dokładniejsze w wykrywaniu problemów zdrowotnych niż tradycyjne dane z czujników (np. tętno czy saturacja).

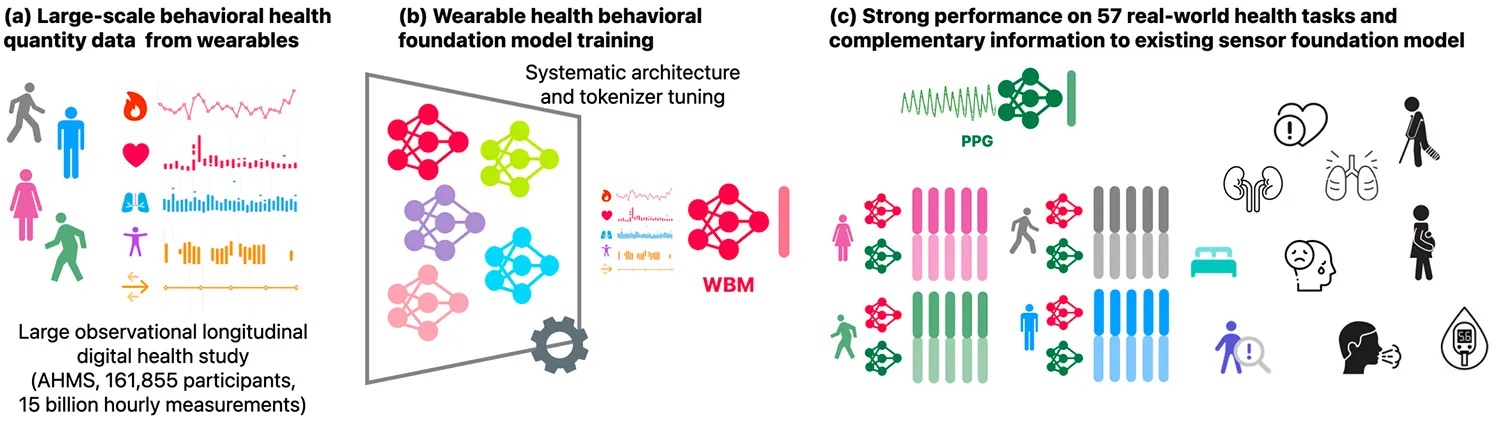

Model WBM (Wearable Behavior Model), wytrenowany na ponad 2,5 miliarda godzin danych z Apple Heart and Movement Study (AHMS), przewyższył klasyczne modele PPG (np. wykrywające migotanie przedsionków) w wielu zadaniach:

- 92% skuteczności w wykrywaniu ciąży,

- lepsze wyniki w diagnozowaniu infekcji, jakości snu, urazów czy chorób serca,

- model uczy się na podstawie 27 mierzalnych parametrów zachowania (np. tempo chodu, sen, zmienność tętna).

WBM nie zastępuje danych z sensorów – uzupełnia je, tworząc dokładniejszy obraz zdrowia użytkownika na przestrzeni tygodni, nie sekund. To przełomowe podejście może zrewolucjonizować wczesne wykrywanie zmian zdrowotnych dzięki Apple Watcha i iPhone’a.

Produkty Apple przekształcają opiekę nad pacjentami w Emory Healthcare

Jeśli artykuł Nowy model AI Apple wykrywa stany zdrowotne z dokładnością do 92% nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.